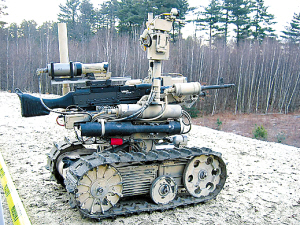

■美国SWORD狙击机器人能进行精确射击

战争既残酷又昂贵,这就是为什么美国国防部希望在2015年前用机器人取代其三分之一的战车和军人,因为机器人会更适应战场需求,即便杀人也不会有负罪感,而且“军方不必向它的亲属发慰问信”。

但美国陆军仍对机器人存在失控的担忧,研究人员正在研究如何让机器人使用致命武力时遵守国际法和交战规则。有消息称,自主机器人将在未来20年内正式登上战场。

“道德适配器”

负责这项研究的罗纳德·阿金博士正在制定一套机器人交战规则,以确保它们能根据道德准则使用致命武力。换句话说,阿金博士正在努力创造一种人工道德意识。他认为,让机器人上战场还有另一个原因,那就是它们的举动可能比人类更有人情味,因为一名士兵可能会受到战场压力的影响,而战场压力却不会影响机器人的判断。

阿金采取的方法就是创造一种被称为“潜在行动的多维数学决策空间”的软件系统。据阿金及其同事帕特里克·乌拉姆提交的一份研究报告称,这套融合了人类悔恨、同情、同意、内疚等情绪的软件安装到战争机器人后就能扮演“道德适配器”的角色,把机器人所有可能的行动分为“道德”和“不道德”两种,并根据需要选择相应武器系统。机器人在使用大威力武器前必须经过“道德适配器”审核,当使用武器的“负罪感”低于标准值才可行动。

阿金举了一个例子,美军常用的无人驾驶飞机携带有GBU精确制导炸弹,“地狱火”激光制导导弹和机枪,当无人机准备打击某个目标时,其自带的“道德适配器”觉察到动用GBU炸弹可能导致平民伤亡,便会及时作出“有罪”判定,GBU武器会被停用,而无人机下一步计划发射威力更大的“地狱火”导弹时,“道德适配器”将发出更强烈的“有罪”提示,此时由于“有罪”提示达到最大允许量,无人机的武器系统将会失效。

实际上,阿金团队的工作与上世纪50年代科幻作家阿西莫夫提出的“机器人三定律”有相似之处。但阿西莫夫提出的规则是为了防止机器人在任何情况下伤害人类,而阿金的准则是为了确保机器人不在“不道德”的情况下杀害人类。

不同的意见

美国《华盛顿邮报》预测,用不了20年,美国机器人甚至能从根本上改变“战争屠宰场”的面貌,常规战争乃至种族灭绝屠杀将因美国“机器人和平部队”的干预而消失。

但美国学者H.G.韦尔斯是个坚定的“机器人战争”反对者,他担心机器人的知识面广泛,却冷酷无情,“机器人与人类的思维差距,就像人类与野兽之间的差距那样大,它们会产生类似希特勒那样的种族灭绝情绪”。韦尔斯称,大多数真人士兵会由于受到战场压力影响而很少射击,其余士兵中的大部分人也只是向大致方向倾泻子弹,只有约1%的少数士兵会带着杀意瞄准敌人开火。战争机器人的瞄准精确度是人类无法比拟的,而且开火时毫不犹豫,它们一旦上战场,将使战争变得更加残酷。

对于阿金团队开发“理智型机器人”,韦尔斯认为这从理论上看是令人钦佩的,但即使道德准则可以编入机器人程序,仍存在一些预料不到的风险。战场上的情况瞬息万变,这对于人类和机器人来说都是一个问题。

|